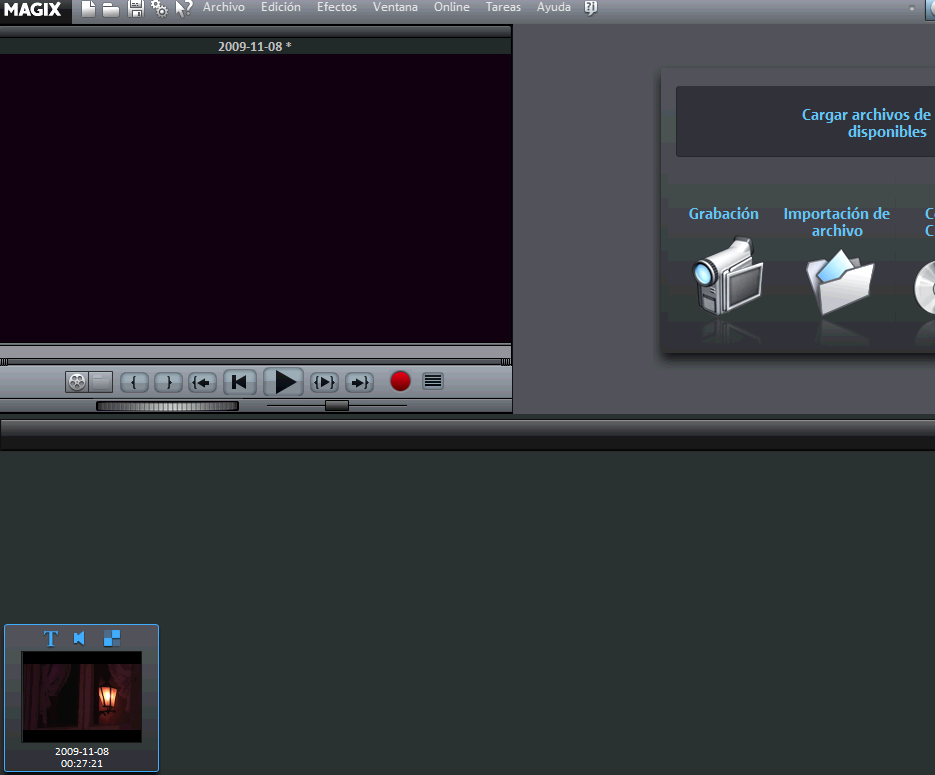

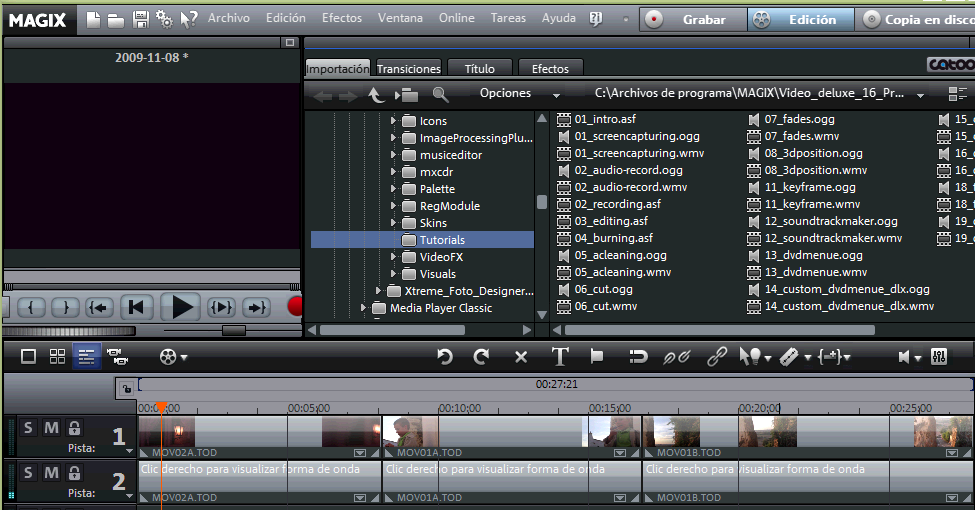

Este artículo se publicó en noviembre de 2009

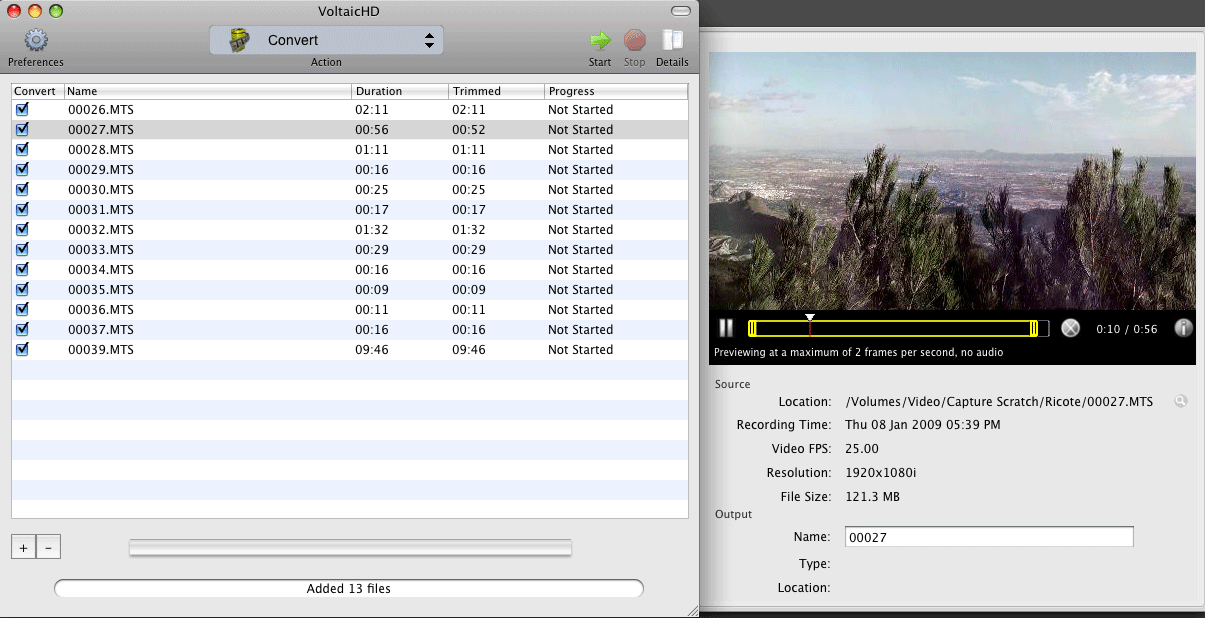

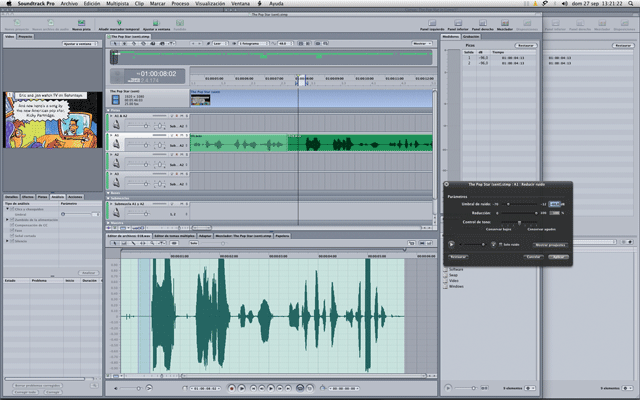

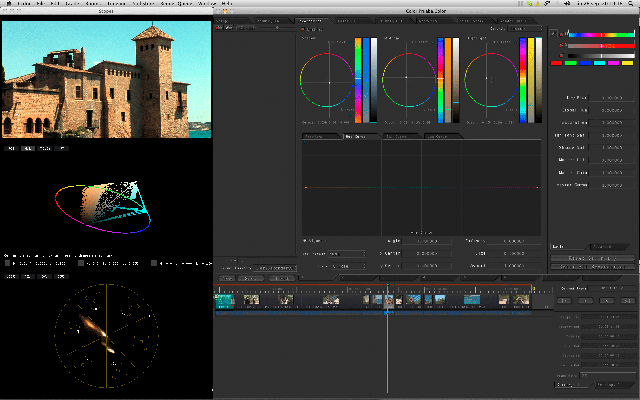

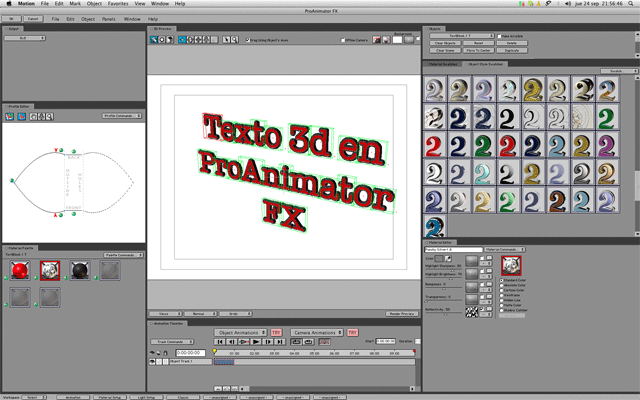

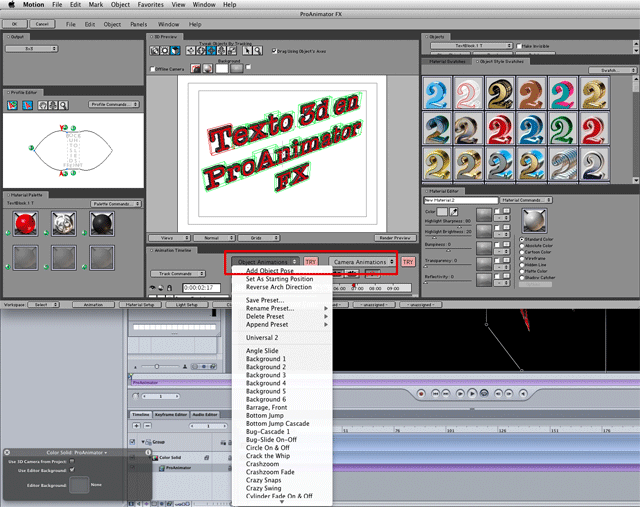

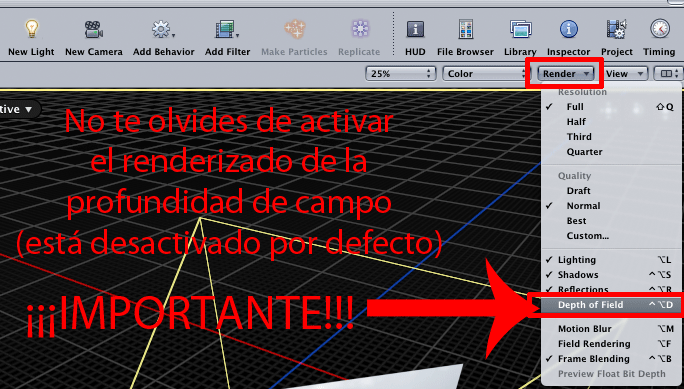

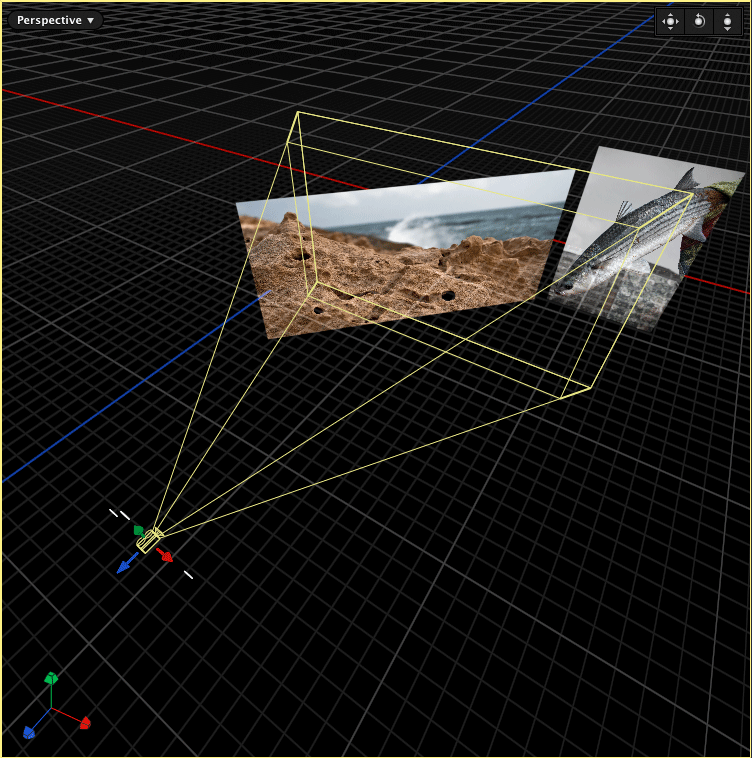

De la mano de nuestro estimado Zoom Leo, aprende el manejo de esta interesante herramienta incluida en Sony Vegas.

1 er. Parte wmv 12mb.

1 er. Parte wmv 12mb.

2a. Parte 34.2 mb mp4.

2a. Parte 34.2 mb mp4.

Autor: zoom_leo